Вышел DeepSeek-V3 - самая большая модель с параметрами 671B

Фанаты искусственного интеллекта, внимание! DeepSeek-V3 только что вышел и стал самой крупной моделью по весу, с параметрами в 671B. Это действительно впечатляет!

Знаете ли вы, что OpenAI, Anthropic и Google тратят на своих исследователей примерно столько же, сколько DeepSeek выделяет на обучение своей модели — всего 5.3 миллиона долларов? Это довольно скромная сумма для таких масштабов. И результаты бенчмаркинга показывают, что DeepSeek-V3 находится на уровне Sonnet 3.5 и GPT-4o. Не плохо, правда?

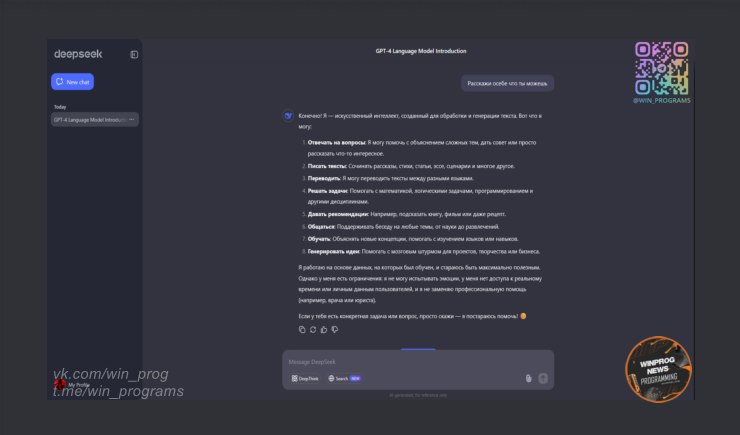

А вот что забавно: как модель представляет себя на разных языках. В англоязычной версии она гордо именует себя DeepSeek-V3, а вот в русскоязычной версии называет себя моделью OpenAI. Интересный поворот, не находите?

Дополнительные сведения:

- Модель отлично справляется с задачами в кодировании и математике. Если вы хотите попробовать её возможности, можете сделать это здесь

❗ Следите за новостями и оставайтесь на волне технологий!

|

Информация: Посетители, находящиеся в группе Гости, не могут скачивать файлы с сайта. Зарегистрируйтесь!. |

И будьте в курсе первыми!